Dans certains cas, on se demande pourquoi Google indexe des pages scrapées. Mais également, plagiées sans grand intérêt de point de vue expérience utilisateur. Alors que dans la plupart des cas, l’algorithme sait faire la différence. Ainsi, il fait en sorte de ne pas montrer les pages sans contenu original et unique. Et pourtant de gros sites passent encore entre les mailles du filet.

C’est en substance ce qu’a demander un internaute Canadien:

Que fait Google pour détecter et enlever des pages de résultats des grands sites sans contenu unique, comme les sites d’avis sans avis ou comme les pages Facebook non officielles ?

Les réponses apportées

L’internaute précisant bien qu’il s’agit de grands sites connus et influents, Matt Cutts rétorque qu’il ne s’agit pas de taille de site, chose qu’on a du mal à croire quand on voit qu’après l’arrivée de Penguin 2.0, les grandes marques sortent d’avantage devant les sites e-commerces des revendeurs.

L’internaute précisant bien qu’il s’agit de grands sites connus et influents, Matt Cutts rétorque qu’il ne s’agit pas de taille de site, chose qu’on a du mal à croire quand on voit qu’après l’arrivée de Penguin 2.0, les grandes marques sortent d’avantage devant les sites e-commerces des revendeurs.

Le porte-parole du Search continue son élocution en expliquant que l’équipe de Spam, tout comme l’algorithme, cherchent à refléter des résultats pertinents, quelle que soit la taille du site. Mais d’un autre côté, il avoue bien volontiers qu’il existe encore des pages sans contenu valable qui sont toujours indexées. Des pages de type avis, annuaire, répertoire, business, listing de téléphones…dont le contenu est scrappé et donc plagié.

[toggle style=”closed” title=”Voir un exemple plus parlant”]

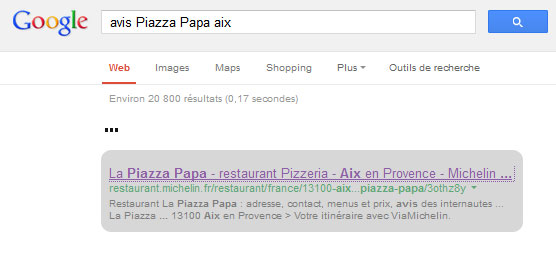

Les sites d’avis: A titre d’exemple, prenons la requête suivante:

|

avis Piazza Papa aix |

Elle nous renvoie sur des résultats présentant des avis. En page 1 on trouve Michelin qui n’a pas de description, de photo, de prix de menu et qui n’a pas suffisamment d’avis pour afficher une note moyenne. Et pourtant Google le fait sortir en 7ème position. [/toggle]

[/toggle]

Dans le cas où les résultats ne reflètent pas pertinemment le besoin de l’internaute, Matt invite les internautes mécontents à dénoncer les pages de ces sites dans un spam report.

Au final, je pense que la requête influe sur la qualité de résultat. Une requête populaire présentera surement plus de bons sites en première page, qu’une requête où il n’y a quasiment rien à afficher, et que par défaut mieux vaut afficher des résultats moins pertinents que pas de résultats du tout.

Lire aussi : Pourquoi certaines pages avec de mauvais liens se positionne parfois devant?

et Comment Dan Petrovic détourne les résultats de Google avec du duplicate content