Il est clair que si un internaute lambda possède les moyens de faire du reverse-engineering. Mais également, découvrir le réseau de liens de ses concurrents. De plus, les moteurs de recherche ont des moyens eux bien plus décuplés pour remonter le linking. Alors inutile de jouer les maestros en pensant être plus fort que Google ou Bing. Ainsi, que d’imaginer pouvoir cacher ses tactiques de linking pour s’épargner les filtres pénalisants de Google.

Comment Google fait-il pour remonter le linking

Il utilise plusieurs indicateurs pour identifier les convergence de liens. A l’instar d’un détective, le moteur part à la recherche d’empreintes laissées par ci par là par les webmasters. Toutes sortes d’informations sont rassemblées et passées dans un filtre pour éventuellement trouver un pattern suspicieux.

Il utilise plusieurs indicateurs pour identifier les convergence de liens. A l’instar d’un détective, le moteur part à la recherche d’empreintes laissées par ci par là par les webmasters. Toutes sortes d’informations sont rassemblées et passées dans un filtre pour éventuellement trouver un pattern suspicieux.

Voyons voir les éléments pris en compte :

La pertinence thématique du contenu (Topical PageRank)

Revenons en arrière, en 2003, où un génie des maths, un dénommé Taher Haveliwala, embauché par Google propose un système de filtration du page-rank par pertinence afin de fournir plus de jus si les thématiques coïncident. La pertinence deviendra peu à peu les années suivantes, le nouveau Graal des webmarketeurs. Ainsi les liens hors relation sont certes dépréciés. Mais ils sont bel et bien un indicateur d’échange de liens ou de liens factices. Ce qui est encore plus évident quand les langues de deux sites liés ne correspondent pas.

Revenons en arrière, en 2003, où un génie des maths, un dénommé Taher Haveliwala, embauché par Google propose un système de filtration du page-rank par pertinence afin de fournir plus de jus si les thématiques coïncident. La pertinence deviendra peu à peu les années suivantes, le nouveau Graal des webmarketeurs. Ainsi les liens hors relation sont certes dépréciés. Mais ils sont bel et bien un indicateur d’échange de liens ou de liens factices. Ce qui est encore plus évident quand les langues de deux sites liés ne correspondent pas.

Depuis le topical page rank, Google n’a cessé d’investir dans la compréhension de la sémantique. De ce fait, cella lui permet de fonder un modèle basé sur l’utilisation contextuelle des mots d’un langage. Notamment en faisant l’acquisition en juillet 2010 de MetaWeb, qui deviendra plus récemment la base de données du Knowledge Graph.

Les propriétaires de sites et de domaines et leurs partenaires

Si vous avez déjà eu l’occasion d’utiliser le site NetComber d’André Weyher, vous avez alors admiré la facilité déconcertante de connaitre et d’identifier le propriétaire d’un site et ses partenaires. Même si tous les résultats fournis par cette application ne sont pas corrects, ils sont des preuves éventuelles. Google utilise probablement des algorithmes plus complets, basés sur d’avantage d’entrées en provenance de Chrome, des requêtes de mots clés et l’expérience utilisateur, afin de fournir des preuves qui en s’ajoutant les unes aux autres fourniront les éléments clés pour fonder l’intime conviction des juges Penguin et Panda. Parmi les indicateurs :

- Whois : nom, adresse, email

- Ville de l’hébergement, adresse IP

- Infrastructure du serveur, modules installés

- Pseudo / identifiant de comptes

- Gravatars, signature de commentaires, de forums

- Similitude du code source du site, du template

Le poids des liens dans l’expérience utilisateur

Les liens d’une page ou d’un article n’ont pas le même poids selon l’emplacement où ils se trouvent, selon comment ils sont affichés (taille, police, couleur, gras) et selon le nombre de liens totaux sur la même page. Pour aller plus loin, Google se sert des rich snippets pour en apprendre plus sur vos zones chaudes, et le HTML5 en fait de même en nomant et organisant chaque <div> d’une page.

De la même manière Matt Cutts nous confirme la prise en compte de liens répétés sur chaque page (liens de footer, blogroll) dans la vidéo comment Google considère les liens site-wide.

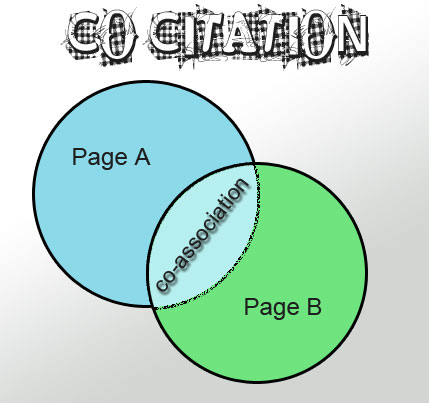

La co-association (co-citation), sémantique et duplicate content

Grâce à la centaine de clients dans son giron et une approche pragmatique, Rand Fish de SeoMoz, a émis la possibilité de Google de compter et d’utiliser les co-citations de sites externes comme une ancre de lien, avec un ratio certes différent. C’est d’après moi simplement une conséquence de la pratique du moteur de recherche de rechercher les associations, les mentions réciproques, les apparitions conjointes de mots et de phrases pour comprendre la signification de la sémantique et ainsi donner plus de poids aux liens hébergés sur la page.

Pour faire cela, Google regarde les autres pages qui utilisent des phrases et des mots similaires dans un contexte ressemblant. D’un côté il en apprend sur la sémantique, et de l’autre il active le mode ‘duplicate content’ et déprécie les plagieurs éventuels.

Conclusion

A travers un panel d’outils, Google cherche à remonter les réseaux de liens, détruire les fermes de liens, les systèmes automatiques et renforce sa lutte contre le webspam. Pour reprendre l’expression de Yann, vainqueur du Sentimancho, ‘je parle à Google’ renforce encore la compréhension du moteur de votre réseau et de vos partenaires. Mieux vaut être clean !